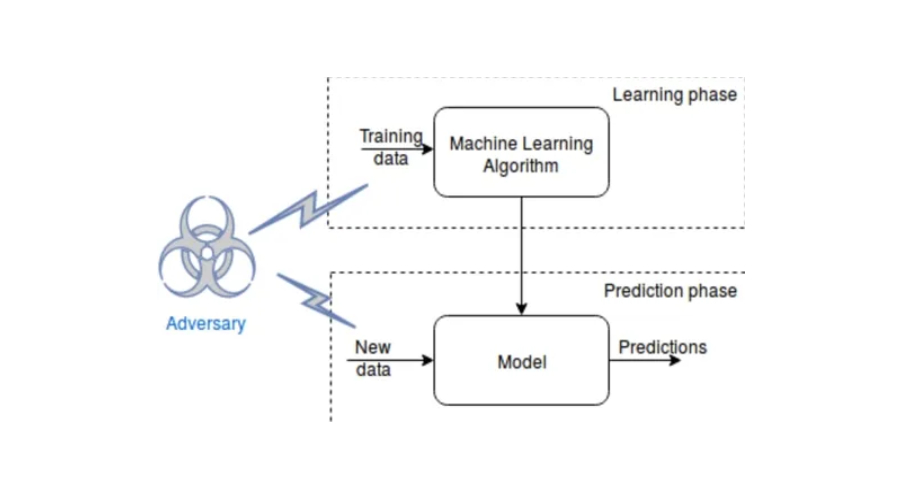

对抗性学习是一种机器学习技术,会对模型进行对抗性训练,这种训练的目的是通过误导模型做出不准确和错误的预测,以此来提高训练后的模型对现实世界中数据的变化,使其更加稳健。

对机器学习模型的对抗性攻击

它对机器学习模型的攻击可以分为两类:白盒攻击和黑盒攻击。白盒攻击是攻击者可以访问模型的架构和参数的攻击,黑盒攻击是攻击者无法访问此信息的攻击。一些常见的对抗性攻击包括FGSM(快速梯度符号法)、BIM(基本迭代法)和JSMA(基于雅可比矩阵的显着性图攻击)。

为什么对抗性学习对于提高模型稳健性很重要?

对抗性学习对于提高模型的鲁棒性很重要,因为它有助于模型更好地泛化。此外,对抗性学习有助于模型识别和适应数据结构,这对于稳健性至关重要。而且它还能有助于检测模型中的弱点并提供有关如何改进模型的见解。

如何将对抗性学习纳入机器学习模型?

将对抗性学习纳入机器学习模型需要两个步骤:生成对抗性示例并将这些示例纳入训练过程。

对抗样本的生成和训练

可以使用多种方法生成,包括基于梯度的方法、遗传算法和强化学习。基于梯度的方法是最常用的。它们涉及计算有关输入的损失函数的梯度,然后在增加损失的方向上修改信息。

对抗样本可以被纳入训练过程,通过对抗训练和对抗增强。在训练期间使用对抗性示例来更新模型参数。对抗性增强涉及向训练数据添加对抗性示例以提高模型的鲁棒性。

它的增强是一种在实践中广泛使用的简单有效的方法。这个想法是将对抗性示例添加到训练数据中,然后在增强数据上训练模型。该模型经过训练,可以为原始示例和对抗示例预测正确的类标签,使其对数据的变化和失真更加稳健。

对抗性学习的应用实例

对抗性学习已应用于各种机器学习任务,包括计算机视觉、语音识别和自然语言处理。

在计算机视觉中,它被用于提高图像分类模型的鲁棒性。如被用于提高卷积神经网络(CNN)的稳健性,从而提高未见数据的准确性。

在语音识别中,对抗性学习提高了自动语音识别(ASR)系统的鲁棒性。该领域中的对抗性示例旨在以人类无法察觉但会导致ASR系统错误转录的方式改变输入语音信号。对抗性训练已被证明可以提高ASR系统对这些类型的对抗性示例的鲁棒性,从而提高准确性和可靠性。

在自然语言处理中,对抗性学习已被用于提高情感分析模型的鲁棒性。此NLP领域中的对抗性示例旨在以导致模型预测错误和不准确的方式操纵输入文本。对抗性训练已被证明可以提高情绪分析模型对这些类型的对抗性示例的鲁棒性,从而提高准确性和鲁棒性。