第十一届国际表征学习会议(International Conference on Learning Representations,下文简称ICLR)预计将于5月1日至5日在卢旺达首都基加利线下举办。并于近期公布论文接收结果:网易伏羲共有3篇论文入选,包含oral presentation paper和spotlight presentation paper各一篇;论文内容涉及强化学习、自然语言处理等方向。

ICLR是人工智能与机器学习领域最顶级的学术会议之一,与ICML、NeurIPS并称机器学习三大会。作为机器学习领域最年轻的会议,至今仅有10年的历史。但由于深度学习日新月异的发展以及大会牵头人Yoshua Bengio、Yann LeCun的影响力,ICLR会议很快便得到研究者们的认可,在Google Scholar的学术会议/杂志排名中,ICLR目前排名第十位。

本次ICLR会议共收到接近5000篇的投稿,中稿率为31.8%。其中所有中稿论文的top 5%为oral presentation,top 25%为spotlight presentation。

以下为此次入选的三篇论文概要:

《Tailoring Language Generation Models under Total Variation Distance》

基于全变差距离的语言生成模型

关键词:语言模型,文本生成

涉及领域:text generation,language model

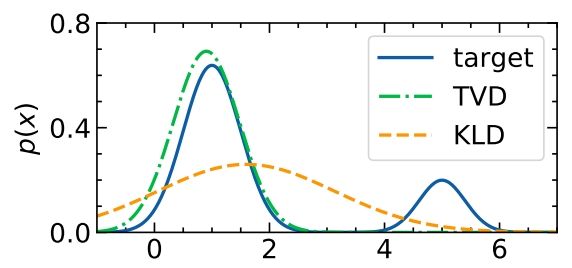

文本生成是自然语言处理技术中的常见任务,并在网易有非常广泛的应用场景,如文字游戏、智能NPC、文章辅助创作、歌词辅助创作等。目前文本生成的标准范式是采用最大似然估计(MLE)作为优化方法。从分布的角度来看,MLE实际上最小化了真实数据和模型分布之间的KL散度(KLD)。但是,这种方法迫使模型对所有训练样本(无论这些样本质量如何)都分配了非零的概率。此外,在试图覆盖数据分布中的低概率区域,模型系统地高估了损坏的文本序列的概率,我们猜测这是自回归解码时文本退化的主要原因之一。为了补救这个问题,网易伏羲和清华大学黄民烈教授研究团队利用对异常值鲁棒的全变差距离(TVD),开发了合适的方式应用于语言生成。

实验表明KLD对于异常点是更敏感的,TCD是鲁棒的。

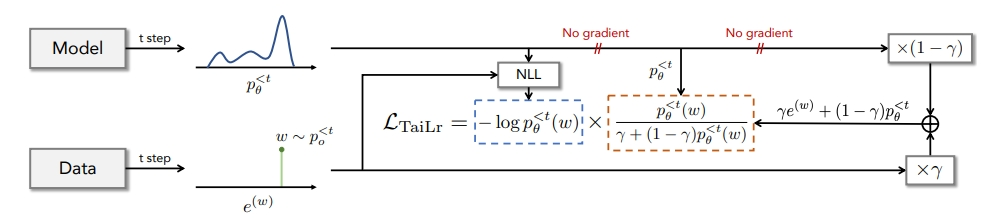

然后引入TaiLr目标来平衡TVD的估计。直观地说,TaiLr降低了具有低模型概率的真实数据样本的权重,并且具有可调整的惩罚强度。实验结果表明,我们的方法在不牺牲多样性的情况下减轻了对退化序列的高估,并在广泛的文本生成任务中提高了生成质量。

《EUCLID:Towards Efficient Unsupervised Reinforcement Learning with Multi-choice Dynamics Model》

EUCLID:基于多项选择动态模型的高效无监督强化学习

关键词:无监督强化学习,预训练模型

涉及领域:Model-based RL,Unsupervised RL

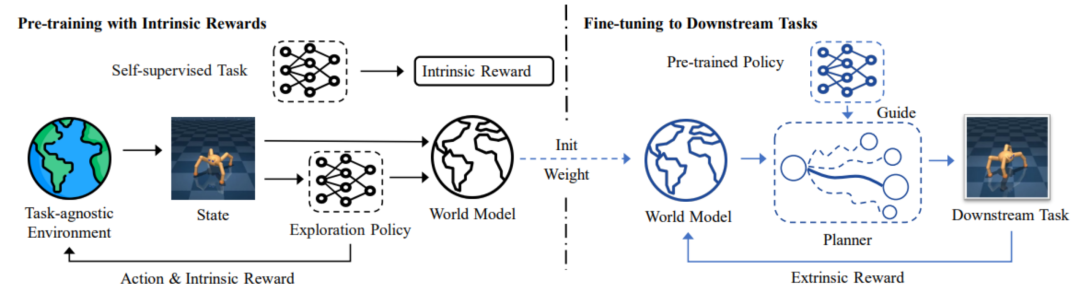

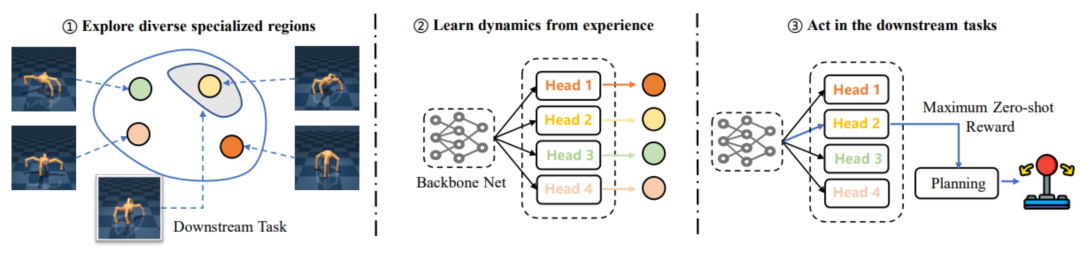

强化学习(RL)通常需要大量的交互数据和精心设计的特定任务奖励进行策略学习,从而导致低的样本效率和难以快速泛化到新的下游任务。因此,无监督强化学习应运而生,即通过无监督的方式在无标签的大量样本中进行预训练,以此为先验知识达到在多个下游任务种快速适应的效果,这一训练范式能够促进强化学习在充满未知任务的现实世界的落地应用。

但过往的工作往往专注于通过探索环境预训练出一个具有不同技能的策略,而仅仅通过多样化探索的预训练方式难以保证下游任务的性能提升,甚至可能导致预训练消耗越大,性能越低的“不匹配”问题。因此,网易伏羲和天津大学深度强化学习实验室团队提出了EUCLID框架,引入了基于模型的RL范式,通过长时间的预训练,从精确的动态模型中获益,以实现快速的下游任务适应和更高的采样效率。在微调阶段,EUCLID利用预先训练的动态模型进行策略引导的规划,这样的设置可以消除由不匹配问题引起的性能震荡,获得单调的性能提升。

EUCLID框架是首个将世界模型引入无监督强化学习的框架,解决了此前无监督强化学习难以在现实场景应用的最大问题——不匹配问题,能够在低成本的无标签数据预训练的基础上,只使用100k的交互样本快速适应多个下游任务,实现了基于无监督的高效预训练框架,相比model free算法提高20倍采样效率,并在URL社区的多个标准benchmark中达到接近上界的性能。在实际应用方面,EUCLID框架将对基于强化学习的游戏竞技机器人的训练起到显著降本增效作用。这是由于实际的游戏场景不同于学术研究中采用的模拟环境,需要大量计算资源来运行,而强化学习算法的训练又需要成规模地运行多个游戏实例进行样本采集,导致训练成本高昂。EUCLID框架可以有效地对游戏场景进行数字孪生建模,一旦完成建模,强化学习算法可以较少甚至不依赖于原始游戏场景进行样本采集。神经网络化的世界模型使得超大规模的样本采集和强化学习训练成为可能,这将极大提高游戏竞技机器人的训练效率,节省大量训练成本。

《Neural Episodic Control with State Abstraction》

基于状态抽象的神经情景控制

关键词:情景控制、状态抽象

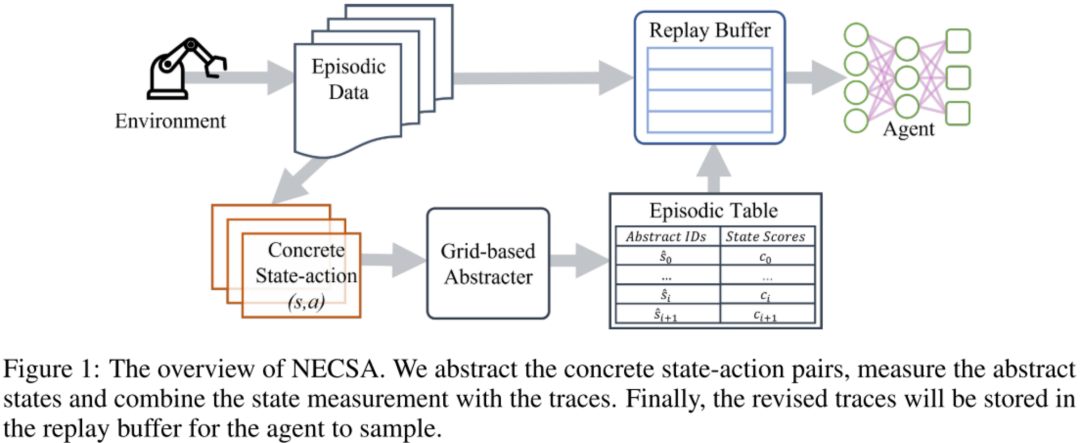

情景控制(episodic control)方法通常会将Agent经历过的高价值样本保存到内存当中,并在学习的过程中利用内存中的已知信息来加快模型收敛,提升样本利用率。然而,已有的方法往往只记录真实的state、action和state value,而没有考虑样本之间的隐层信息(例如,状态转移、拓扑相似度等等),进而在泛化性、样本利用率等方面仍旧有所欠缺;此外,由于状态信息通常使用浮点数表示,已有方法无法有效存储和检索内存中的信息。

因此,网易伏羲和九州大学Pangu实验室研究团队提出改进的情景控制算法——NECSA(Neural Episodic Control with State Abstraction):

1.利用原始状态之间的多步转移信息,将高维的转移片段抽象到有限的格子空间中;

2.并提出一种高效的状态分析方法,来对格子空间中的状态进行综合评价;

3.最后,这些评价信息会以intrinsic reward的形式来辅助Agent学习,提升高价值样本的学习效率;

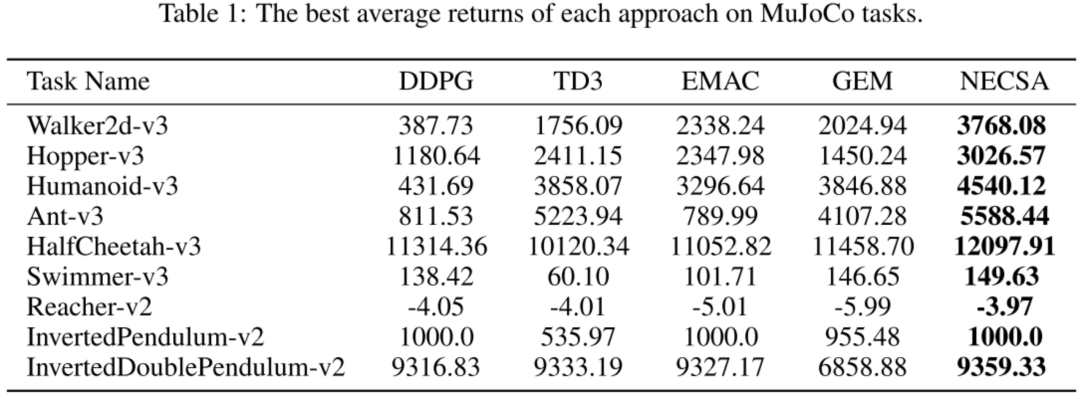

实验结果表明,NECSA在所有的实验环境中都拿到了最高的分数,达到了state-of-the-art水平。

此外,NECSA可以作为一个独立的模块来方便的集成到已有的强化学习算法中,具备很强的通用性。NECSA的典型应用场景之一是游戏竞技机器人的训练。对于真实游戏场景中复杂且高维的状态表征,NECSA给出了一种基于状态分析来增强学习效果的新思路,一方面可以更好更快地达到优化目标(如:提升机器人竞技水平、拟人性等),另一方面还有可能提供良好的模型可解释性。网易伏羲未来将在多个游戏场景中推动NECSA方法的实际落地。

特别感谢清华大学黄民烈教授团队对《Tailoring Language Generation Models under Total Variation Distance》的重要研究贡献,感谢天津大学深度强化学习实验室对《EUCLID:Towards Efficient Unsupervised Reinforcement Learning with Multi-choice Dynamics Model》的重要研究贡献;以及九州大学Pangu实验室对《Neural Episodic Control with State Abstraction》的重要研究贡献。

网易伏羲作为国内专业从事游戏与泛娱乐AI研究和应用的顶尖机构,正在把AI技术和产品开放给更多合作伙伴,让人工智能技术惠及更多领域;目前,网易伏羲已服务超200家客户,应用日均调用量超数亿次。