人工智能之面部表情动画捕捉:技术演进与未来展望

一、面部表情动画捕捉的定义与重要性

面部表情动画捕捉是通过技术手段记录并还原人类面部细微表情变化的过程,其核心目标是为虚拟角色赋予真实的情感表达能力。在影视、游戏、虚拟现实(VR)、增强现实(AR)及在线教育等领域,该技术已成为提升沉浸感与交互体验的关键环节。随着人工智能(AI)的发展,面部表情捕捉正从依赖硬件设备的复杂流程,向智能化、无设备化方向快速演进。

二、传统与AI驱动的面部表情捕捉技术

1、传统硬件设备与流程

早期技术依赖光学传感器、标记点或专用设备(如Faceware的Mark IV headcam)进行捕捉。例如,电影《阿凡达》中纳美人的面部动画,通过演员佩戴的标记点设备实现高精度捕捉。此类方法需专业设备、多镜头协作及后期绑定处理,成本高昂且流程复杂。

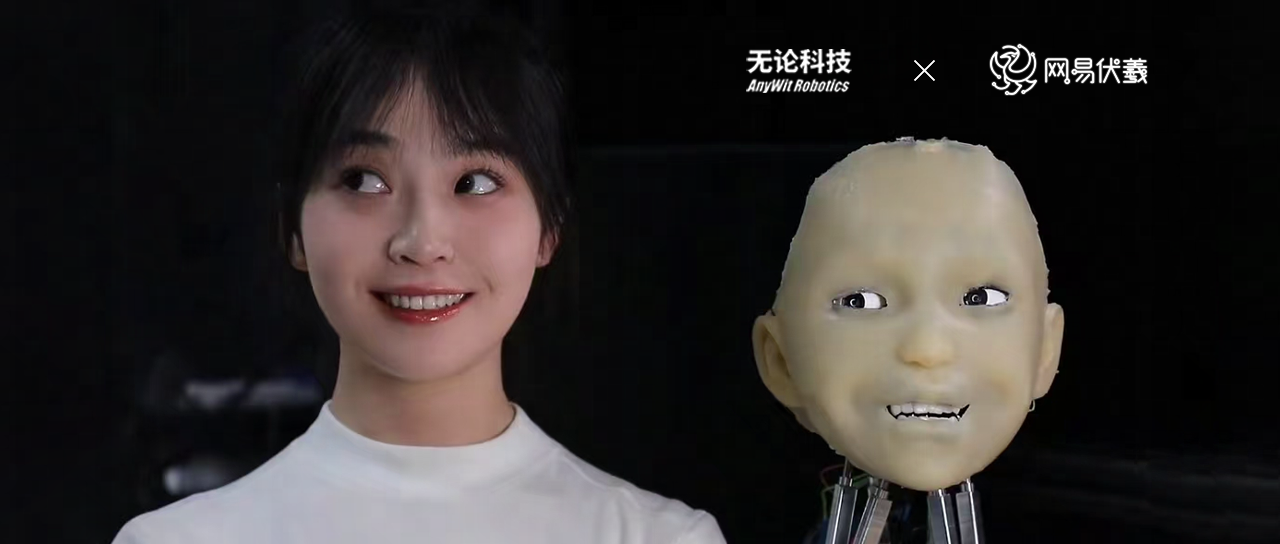

2、AI驱动的无设备解决方案

近年来,AI技术突破了传统硬件的限制。例如:

- Runway的Act-One:利用单一摄像机(如手机)录制演员表演,通过AI算法精准提取微表情(如眼神、嘴角颤动),并将其映射到虚拟角色上,无需绑定设备。

- ZegoAvatar:基于移动端摄像头与深度学习算法,实时捕捉52种面部表情维度及头部姿态,直接驱动虚拟形象,广泛应用于社交、游戏与在线教育。

- Playmate(ICML 2025):通过3D隐式空间解耦面部属性(表情、唇部动作、头部姿态),结合情绪控制模块,实现音频驱动的高质量肖像动画生成。

三、面部表情捕捉的核心应用场景

1、影视与动画制作

AI技术简化了传统复杂的面部动画流程。例如,Runway的Act-One已用于生成电影级逼真角色,而Faceware系统在《猩球崛起》中成功还原凯撒的细腻表情。

2、游戏开发

游戏引擎(如Unreal Engine)集成AI面捕技术后,可实时生成角色表情。例如,MetaHuman Creator结合Live Link Face,允许开发者通过iPhone摄像头捕捉演员表演,并直接映射到高保真数字角色上。

3、虚拟现实与增强现实

在VR/AR场景中,面部表情捕捉增强用户与虚拟环境的互动。例如,ZegoAvatar技术通过实时渲染用户表情,使虚拟化身在社交平台中自然表达情感。

4、在线教育与医疗

AI面捕技术被用于远程教学,通过捕捉教师表情提升课堂感染力;在医疗领域,抑郁症诊断系统通过分析微表情数据库(如0.2秒的情绪信号)辅助心理评估。

四、技术挑战与解决方案

1、精度与实时性平衡

- 挑战:复杂表情(如混合情绪)及低光照环境下的捕捉精度不足。

- 解决方案:深度学习算法(如卷积神经网络)优化特征提取,结合多模态数据融合(语音、肢体动作)提升鲁棒性。

2、隐私与伦理问题

- 挑战:面部数据采集涉及敏感信息,需符合隐私保护法规。

- 解决方案:采用数据脱敏技术(如匿名化处理),并引入AI审核机制(如Runway Act-One的公众人物内容检测)。

3、计算效率与硬件适配

- 挑战:高精度模型对算力需求高,难以普及。

- 解决方案:轻量化算法设计(如ZegoAvatar的移动端优化)及国产设备(如FACEGOOD P2系统)降低硬件门槛。

五、未来发展趋势

1、多模态融合与自动生成

未来技术将结合语音、肢体动作等多源数据,实现更自然的交互。例如,Playmate通过解耦面部属性与情绪控制模块,支持音频驱动的个性化动画生成。

2、AI辅助创作与实时渲染

AI将深度参与动画制作全流程,从表情设计到绑定优化,显著缩短周期。例如,Unreal Engine的Control Rig工具链支持自定义面部控制器,实现毫秒级实时反馈。

3、轻量化与普及化

随着算法优化与国产设备(如FACEGOOD P2)的推出,面部捕捉技术将逐步走向消费级市场。例如,普通用户可通过手机摄像头完成专业级动画制作。

六、结语

人工智能驱动的面部表情动画捕捉技术,正在重塑数字内容创作的边界。从传统硬件到无设备化、从高成本到普及化,技术迭代不断降低创作门槛,同时拓展应用场景的深度与广度。未来,随着AI算法的持续进步与硬件生态的完善,虚拟角色将实现更自然的情感表达,为娱乐、教育及医疗等领域带来革命性变革。