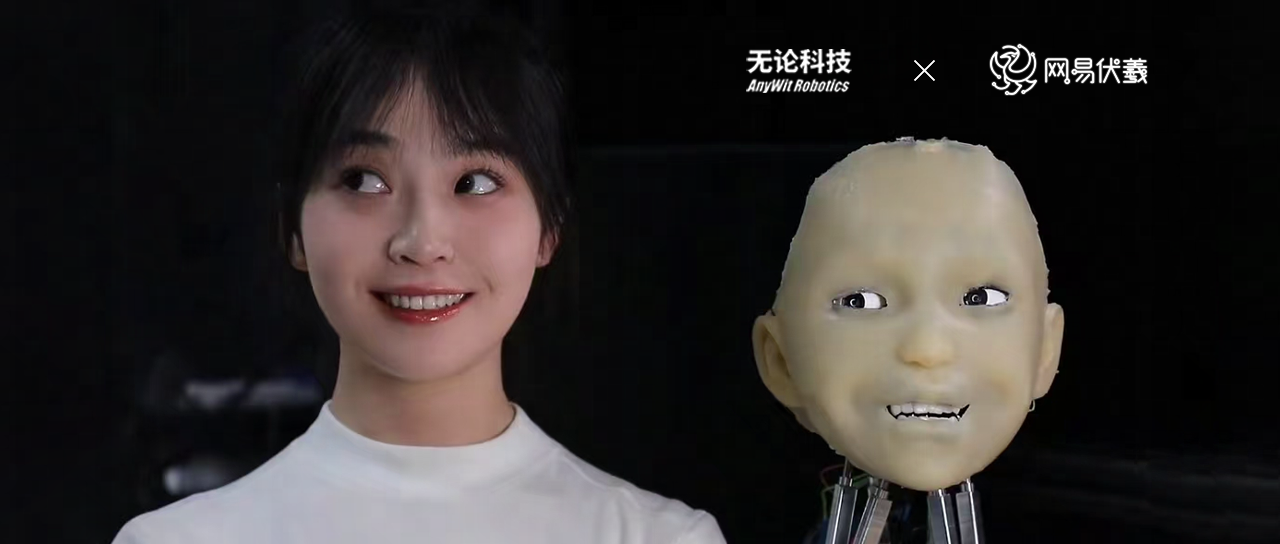

人工智能之面部表情动画捕捉:技术原理与行业应用探索

1、技术原理与核心组件

面部表情动画捕捉是通过人工智能算法实时或离线解析人脸肌肉运动、微表情变化,并将其转化为数字化动画的技术。其核心依赖于计算机视觉、深度学习和3D建模三大领域的协同。首先,利用摄像头或深度传感器采集面部图像或视频数据;其次,通过卷积神经网络(CNN)或Transformer模型识别关键特征点(如眼角、嘴角、眉骨);最后,基于物理引擎或生成对抗网络(GAN)生成与真实表情高度匹配的动画模型。

区别于传统光学标记点捕捉技术,人工智能方案无需在面部粘贴标记点,而是通过无标记点算法直接分析自然状态下的面部动态。这一突破显著降低了硬件成本,同时提升了适用场景的灵活性。

2、技术流程与关键突破

人工智能表情捕捉的流程可分为四个阶段:

数据采集与预处理:通过多角度摄像头或手机设备获取高质量面部图像,并进行光照归一化、去噪等预处理。

特征提取与建模:利用深度学习模型(如FaceMesh、MediaPipe)定位面部468个关键点,构建3D面部网格。

动态表情映射:将捕捉到的肌肉运动数据与预设的动画骨骼绑定,通过算法模拟皮肤形变、皱纹生成等细节。

实时渲染与优化:结合游戏引擎(如Unity、Unreal Engine)输出低延迟、高保真的动画效果。

关键突破包括:基于少量样本的迁移学习技术,可适应不同人种、年龄的面部特征;轻量化模型设计,支持移动端实时渲染;以及对抗生成网络在细微表情(如瞳孔收缩、嘴角微颤)还原中的应用。

3、核心应用场景与价值

影视与游戏制作:为虚拟角色赋予真实表情,例如电影中数字替身的表演、游戏NPC的智能化互动。

虚拟现实(VR)与元宇宙:用户在虚拟社交场景中通过自然表情传递情感,提升沉浸感。

医疗与心理学研究:分析患者的面部表情辅助诊断抑郁症、自闭症等疾病,或用于远程康复训练指导。

人机交互与客服系统:智能助手通过识别用户表情调整对话策略,增强沟通效率。

4、技术挑战与优化方向

尽管技术进步显著,仍需解决以下问题:

数据多样性与泛化能力:模型在极端光照、遮挡或跨人种场景下的准确性下降。

细微表情的捕捉瓶颈:如微小的肌肉颤动、眼神变化仍依赖高精度传感器支持。

实时性与算力平衡:低延迟渲染要求与移动端算力限制之间的矛盾。

隐私与伦理风险:无授权面部数据采集可能侵犯个人隐私,技术滥用(如深度伪造)需法规约束。

优化方向包括:融合多模态数据(如语音、眼球运动)提升表情解读维度;开发边缘计算框架降低云端依赖;建立行业标准数据集与伦理审查机制。

5、未来趋势:从工具到生态的演进

人工智能表情捕捉技术正从单一工具向多场景协作的生态系统演变。例如,结合语音合成与手势识别,构建完整的虚拟人交互方案;与5G网络结合,实现跨地域实时动捕协作;通过开源社区推动技术平民化,使独立创作者也能制作专业级动画。此外,脑机接口的进展可能催生“意念-表情”直接映射技术,进一步突破物理采集的限制。

结语

人工智能之面部表情动画捕捉正在重塑数字内容生产与交互方式。其在娱乐、医疗、教育等领域的渗透,不仅提高了创作效率,更推动了人机共生的可能性。未来,随着算法革新与跨学科融合,这一技术将逐步消除真实与虚拟的边界,成为构建下一代数字社会的核心基石之一。